Поисковая индексация сайта

Индексация - процедура добавления данных о веб-ресурсе в общую поисковую базу. Индексирование осуществляет робот поисковика.

Работы по SEO делятся на проработку внешних и внутренних факторов, по которым определяются позиции сайта в рейтинге. Управление индексацией проекта – это взаимодействие настроек ресурса в его главном файле (можно сказать «верстки») и поисковых краулеров. Присутствие сайтов в индексе поисковых систем продумывается разработчиками еще на стадии создания структуры проекта, верстки и формирования стратегии продвижения. Такая предусмотрительность делает работу ресурса в сети комфортной и успешной.

Методы добавления в индекс

ЛСА-методика - латентно-семантический анализ. Он предполагает обработку данных на естественном языке. С помощью данного анализа определяются логические связи между набором документов и терминологией, встречающейся в них, сопоставляются определенные факторы по всей базе. Для классификации ЛСА-методика используется для выявления значений контекстно-зависимых единиц благодаря обработке крупных текстовых массивов.

ВЛСА - вероятностный ЛСА анализ. Данный метод анализирует взаимосвязи двух типов информации. Используется в обработке речи, машинном обучении и информационном поиске.

Как ускорить индексацию сайта:

- Добавить веб-ресурс в поисковики и социальные закладки;

- Зарегистрировать площадку в популярных каталогах и сервисах, в том числе Я.Вебмастер;

- Осуществить внутреннюю перелинковку;

- Обеспечить правильную структуру ресурса с доступом к любой страничке максимум за три клика от главной;

- Проводить рассылки с линками на ресурс.

- Вести блог - систематически наполнять сайт новым контентом;

- Организовывать RSS-трансляции.

Как ограничить индексирование:

- Задать инструкции в файле Роботс - простейший способ ограничения индексации. Он позволяет запретить добавление в индекс нужных страниц и директорий, оградить от них поисковых ботов;

- Включение тега noindex. Исключает индексацию для конкретной страницы;

- Установка пароля. Позволит отсечь поисковых роботов от контента на сайте;

- Установка 301-го редиректа. С его помощью можно перенаправить роботов поисковиков и пользователей на другие странички.

О работе поисковых краулеров

Яндекс, Google, другие системы разработали алгоритмы, по которым данные по сайтам собираются, анализируются и отображаются в рейтинге на определенных позициях. Поисковая выдача – это результат работы краулеров, где первыми показываются лучшие проекты системы по конкретным запросам. Googlebot, StackRambler, YandexBot и прочие имеют четкие параметры, которым должен отвечать любой сайт, чей владелец хочет зарегистрироваться, ранжироваться и продвигаться в системе. Поэтому первое, о чем надо позаботиться разработчикам – это создание условий для успешного сканирования сайта и добавления ресурса в индекс.

В алгоритм обработки проекта входит и такой показатель, как частота посещения проекта краулером. Абсолютной величины или строго установленного временного периода нет, но есть факторы, которые наиболее влияют на конечный результат:

- число страниц, рекомендуемых к индексированию;

- посещаемость;

- регулярность обновления контента.

Когда на сайт добавляются страницы, поисковые боты узнают о них из таких источников:

- ссылки, ведущие к новым записям из уже известных ботам документов;

- переходы с разных площадок (социальные сети, форумы, прочие).

Поисковые системы заинтересованы в стабильной работе проектов. Поэтому ставится цель – не нарушать функционирование сайта проверками. Считается, что краулеры могут создать проблему, слишком загрузив сервер частыми запросами. С этим связывают такие факты:

- число страниц, которое проверяется за одно посещение, ограничено (точные цифры неизвестны);

- сканирование часто происходит в ночное время.

Гэри Илш - представитель компании Google, в одном из интервью приоткрыл завесу секретности о том, как определяется число сканируемых страниц для каждого сайта. Все происходит через Краулинговый бюджет. В процессе анализа сайта боты опираются на реальные факторы:

допустимая скорость сканирования сайта, что может зависеть не только от качества выполненных работ;

спрос внутри самой компании Гугл (сколько страниц краулер хочет просканировать), за основу берется трафик проекта и другие показатели.

При этом Гугл определяет Краулинговым бюджетом, не желаемый, а возможный результат. Допустим, на сканирование дается максимальный период времени – 100 минут. Число пройденных записей за этот период и будет краулинговым бюджетом проекта. Если сайт ускорится к следующей проверке, то его лимит увеличится, но тоже не сразу, а через несколько недель. Причем, существует и конечное значение (больше страниц за один подход бот не может сканировать).

Для оптимизаторов важно контролировать ряд внутренних факторов, которые непосредственно влияют на снижение краулингового бюджета:

- наличие в доступе к индексации записей, где адрес содержит «лишнюю» информацию;

- дубли документов или просто контента;

- неправильно оформленные страницы с ошибкой 404;

- низкое качество страниц, спам, прочее.

К «лишней» информации относятся адреса, где указаны:

- идентификатор сессии (используется на страницах с отключенными cookies, но практически с теми же целями – сбор инфо о пользователе);

- элементы фильтрации;

- UTM-метки, используемые для отслеживания маркетинговых кампаний сети.

Управление индексацией: как реализуется?

Алгоритмы поисковой системы научились подстраиваться к работе сайта так, чтобы не вызывать его падения или возникновения других технических проблем. В свою очередь, оптимизаторам выгодно учитывать введенные ограничения по количеству страниц, другие особенности. Один из важных принципов, рекомендуемых к соблюдению, – оставлять открытыми к индексации только те документы ресурса, которые принимают участие в его поисковом продвижении.

Предпочтения: как о них заявить ботам?

Внутренняя перелинковка позволяет управлять приоритетами в показах страниц в выдаче. Кроме организации самого процесса ссылочного взаимодействия, необходимо настроить канонические адреса записей, которые считаются предпочтительными при индексировании. Но использовать canonical url надо не всегда, а лишь в случае, если сайт содержит одинаковые страницы. Примером таких записей служит следующее:

- пронумерованные страницы (чтение книги, законов РФ, статей в блоге);

- документы, чьи адреса содержат UTM-метки (свойства товаров);

- наличие на сайте фильтров (похоже на предыдущий пункт, но имеет некоторые особенности);

- прочие.

Важно. Производить настройки необходимо в разделе head. Иначе поисковый бот проигнорирует пожелание оптимизаторов. Используют код такого вида:

Если документ не должен появляться прямо в выдаче, то поисковому боту сообщается канонический адрес.

Роль Robots.txt в индексации

Файл роботс существует практически у каждого сайта, где есть необходимость держать в секрете хоть самую малость информации. Иначе поисковые краулеры считают, что сайт подобен коробке, а все содержимое можно извлекать, использовать, делать доступным общественности.

Внутри файла работают директивы, с помощью которых и управляют индексацией сайта. Кроме того, есть ряд параметров, которые обеспечивают корректность взаимодействий. Например:

- клиентское приложение User-Agent указывает поисковую систему, краулеру которой относится конкретное сообщение;

- директива Disallow сообщает о страницах, которые нежелательно индексировать;

- ранее Crawl-delay использовали для снижения нагрузки на сервер, сегодня Яндекс и Гугл игнорируют эту директиву, но некоторые все равно прописывают;

- для Яндекса прописывают Clean-param, которая запрещает индексировать записи с заданными динамическими параметрами.

Подробнее о том, как настраивать файл robots.txt мы расскажем в одной из следующих публикаций.

Управление индексацией нужной страницы

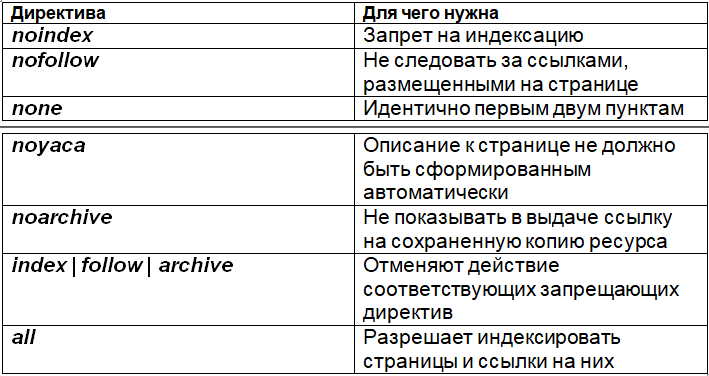

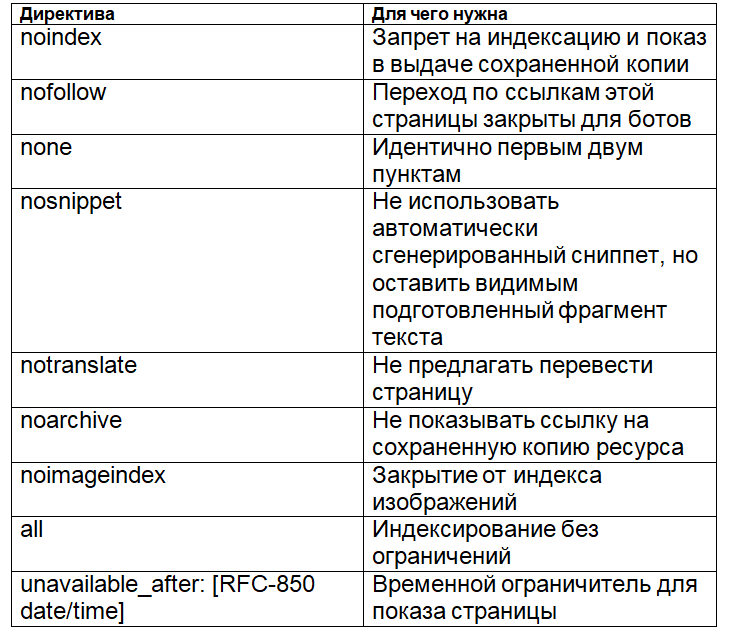

Самый простой инструмент для демонстрации ботам собственных приоритетов – это мета-тег Robots. С его помощью управляют индексацией конкретной страницы. Указание для ботов записывается в том же разделе head:

Могут присваиваться параметры из таблиц (для Яндекс и Гугл отдельно).

Если в коде страницы нет мета-тега robots, то краулеры воспринимают это, как разрешение на индексацию документа, при сканировании следуют по ссылкам. Но следует учитывать, что данный инструмент не отменяет факта проверки страницы (простого ее прочтения). Значит, расходуется краулинговый бюджет. Поэтому оптимизаторы считают, что мета-тега robots больше подходит для закрытия ссылок от перехода по ним.

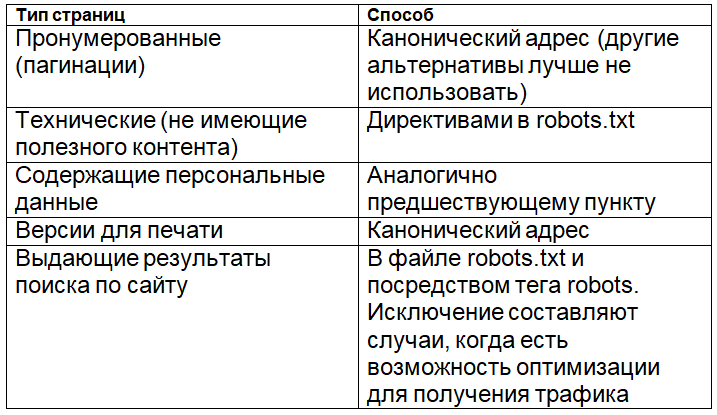

Рекомендации по выбору способов

Очень кратко. Все данные обобщены и приведены в таблице.

Настройка инструментов для управления индексацией считается выполненной успешно, если после ее проведения наблюдается эффективное взаимодействие с поисковыми системами.

Контроль над индексацией

Убедиться в корректности показов документов в выдаче можно несколькими способами.

Панели Вебмастера Яндекса и Google

Обе поисковые системы дают возможность проверять индексацию. Яндекс.Вебмастер предлагается проверять такие параметры:

- общее количество документов, успешно прошедших сканирование;

- настройка мониторинга изменений важных записей с точки зрения маркетинга или по иным признакам;

- проверка статуса URL конкретных страниц;

- выявление причин удаления записей из индекса.

По последнему пункту выделяют такие ошибки оптимизации:

- наличие дублей;

- некорректная переадресация;

- неправильная настройка канонических и нет страниц;

- случайное закрытие записей от индексации в файле robots.txt.

Эти данные позволяют понимать уровень возникших ошибок, устранять их без переписки с администрацией проекта, возвращать документы в индекс.

Предложения Google для вебмастеров не столь перспективны. В специальной консоли можно проверить лишь следующее:

- общее число проиндексированных записей;

- количество закрытых страниц в robots.txt.

Данных по документам отдельно не предоставляется. Поэтому в случае возникновения проблем, оптимизаторам приходиться вручную искать страницы, выпавшие из индекса.

Поисковые операторы

Получить информацию о числе индексируемых страниц могут даже конкуренты, для этого им нужен лишь URL главной страницы. Действие выполняется при помощи специальных операторов, которые максимально уточняют запрос. Например, «site:». Если разница в данных между двумя выдачами многократна, значит, сайт имеет проблемы с технической оптимизацией. Альтернативно, продвижение проекта заточено под работу только одной системы из соображений стратегии раскрутки, по иным объективным причинам.

Оператор «url:» в Яндексе используют для определния статуса конкретной записи.

Панель инструментов RDS бар

Плагин разработан для пользователей браузеров: Opera, Google Chrome и Mozilla Firefox. Добавляется, как вспомогательная панель инструментов. Требуются: специальная, но простая установка, после настройка. При использовании вебмастеру доступны такие данные:

- объемы присутствия сайта в Яндекс и Гугл (отдельно);

- статус текущей записи;

- количество ссылок на сайт (для обеих систем поочередно);

- индекс в других поисковиках (Alex, Bing);

- прочие полезные параметры.

Утилиты для работы с проблемами сайта

Процесс внутренней оптимизации часто выполняют на полностью автоматическом уровне. Выявление ошибок ресурса не составляет исключения. Инструменты помогающие находить и устранять проблемы индексирования иногда называют парсерами.

Эксперты рекомендуют Netpeak Spider. Софт позволяет проверять отклики страниц, находить канонические адреса, определять открытость страницы в robots.txt, а также параметры в мета-тега robots (включен индекс и следование по ссылкам или нет).

Программа Comparser используется для углубленного изучения индексации сайта. Оптимизаторам доступны следующие функции:

- проверка всех страниц;

- выявление документов, присутствующих в рейтингах ПС, но не имеющих внутренние ссылки;

- автоудаление из индекса страниц, представительство которых в рейтингах ПС нежелательно.

Лучшие программы, чтобы сделать анализ оптимизации сайта.

Почему теряется индексация?

Для SEO продвижения важны внутренние параметры сайта. Например, перелинковка сильно влияет на юзабилити проекта, его маркетинговые преимущества, в итоге: трафик. Но участвовать в ссылочном процессе, сформированном внутри проекта, могут только проиндексированные записи. Некоторые из схем перелинковки перестают работать при выпадении всего лишь одного звена. Другие работают даже при трех закрытых от индекса документов. В любом случае, событие снижает объемы поискового трафика, как следствие, числа продаж или заявок.

Основные причины выпадения страниц из индекса выглядят так:

- некорректно настроены отклики 301 или 302 (ведут не на посадочную страницу, а на другую);

- наличие дублей контента;

- ошибка в работе оптимизаторов (страницы по недосмотру оказываются закрытыми от сканирования, способ значения не имеет);

- неправильная настройка документа с ошибкой 404;

- сбои в работе хостинга.

Ранее описаны мероприятия, которые помогут предотвратить удаление страницы из индекса. Если такое событие все-таки состоялось, рекомендуется действовать по следующему шаблону:

- выявить причину удаления;

- исправить ошибки;

- направить документ на индексацию (повторно или впервые).

Способы получения индексации быстрее обычного

Новую или исправленную запись можно добавить в рейтинги поисковиков в ускоренном режиме. Для этого предлагается использовать такой алгоритм:

- Внести добавления в файл sitemap.xml + дата исправлений и указание на заинтересованность в индексировании.

- В Яндексе документ отправляется запрос на «Переобход страниц».

- Формирование ссылочной массы из внешних источников на желаемый к добавлению в индекс документ.

- Добавление ссылок из социальных сетей (хотя сегодня с этим инструментом надо действовать аккуратно, есть новые тонкости настройки).

- Создание условий для высокой посещаемости даже если она обеспечивается за счет электронной рассылки.

- Улучшение качества внутренней перелинковки.

Больше способов: ускорить индексацию страниц.

Подведем итог

Управление индексацией – это основной козырь, которым владеют опытные оптимизаторы. Умение выводить сайт по большому числу запросов в ТОП выдачи базируется на грамотной перелинковке, верстке, профессиональных приемах. О некоторых секретах оптимизаторов рассказано в этой статье.

Если с вашим сайтом приключилась беда, некоторые страницы оказались удаленными из индекса, обратитесь к нашим менеджерам и они помогут исправить ситуацию.

Сегодня актуальны и другие методы блокировки индексации.