- +38 (044) 379-00-67

- Украина с 9:00 до 21:00

Истории успеха

- • заявку на КП оставляйте онлайн или по телефону

- • скидка суммируется с другими акционными предложениями

- • выбирайте подходящий вариант оплаты

- • или разделите эту скидку с другом (по 5% ему и вам)

- • без ограничений по периоду предоставления скидки.

- • больше друзей — больше скидка

- • дополнительные плюшки для самых преданных

- • индивидуальный дисконт при еще большем периоде предоплаты

- • для новых и действующих клиентов

- • бесплатно проверяем прошлого подрядчика

- • вы не теряете, а только выигрываете.

- • гарантируем плавный переход

- • только для новых клиентов

- • предложение суммируется с другими акциями

- • готовы реализовать все рекомендации по улучшению.

- • для фильтра пингвин, панда и других

- • детали акции согласовываются индивидуально

- • возможно сочетание с другими акционными предложениями

- Продвижение интернет-магазина одежды

- Продвижение сайтов недвижимости

- Продвижение строительного сайта

- Продвижение промышленных сайтов

- Продвижение юридического сайта

- Продвижение туристических сайтов

- Продвижение сайтов автосервисов

- Продвижение сайтов бухгалтерских услуг

- Продвижение сайтов медицинских услуг

- Продвижение салонов красоты

- Продвижение гостиничного бизнеса

- Продвижение банковских услуг и МФО

- Продвижение фитнес-клубов

- Продвижение консалтинговых сайтов

- Продвижение сайта стоматологии

- Продвижение транспортной компании, логиста

- Продвижение сайта фотографа

- Продвижение школы танцев

- Продвижение сайта праздничного агентства

- Продвижение окна пвх, пластиковые окна

- Продвижение форекс сайтов

- Продвижение сайта женской тематики

- Продвижение сайта знакомств

- Продвижение мебельных кампаний и магазинов

- Продвижение бизнес порталов

- Продвижение сайта авиа и жд билетов

- Продвижение сайта IT компании

- С погрузчиками и складской техникой

- Продвижение сайта онлайн игр

- Продвижение инфопорталов и сайтов сми

- Продвижение автомобильных сайтов

- Продвижение сайтов продающих межкомнатные двери

- Продвижение магазина парфюмерии и косметики

- Продвижение магазина спортивных товаров

- Продвижение колл-центра

- Продвижение учебных заведений, курсов, тренингов

- Продвижение сайта с услугами ремонта, восстановления

- Продвижение сайта доставки

- Продвижение сайтов бинарных опционов

- Продвижение сайтов рейтингов, обзоров

- Продвижение интернет-магазина автозапчастей

- Продвижение сайтов автомойки

3. Чек-лист внутренней технической оптимизации

Во многом определяющий этап поискового продвижения - это действия, предпринимаемые SEO- специалистами над раскручиваемым сайтом - прежде всего структурные и технические изменения. Ниже приведен тот перечень работ, который способствует ускоренной индексации страниц, улучшенному восприятию ресурса поисковыми системами, а также улучшению поведенческих факторов:

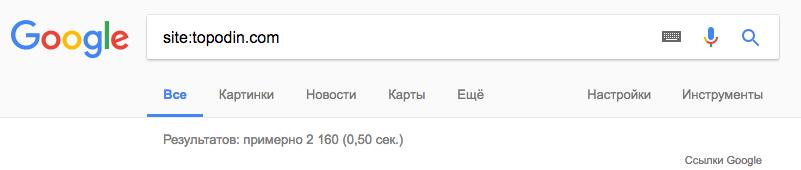

1. Проверена индексация ресурса в Гугле и Яндексе

В том случае, если в одной поисковой системе число проиндексированных страниц отличается в 2 и более раз от того, что добавлены в индекс в другом, то нужно искать ошибки, связанные с индексацией, настройкой файла robots.txt и т.д., и оперативно устранить их. Сделать это помогут сервисы вебмастеров соответствующих поисковиков.

2. Сформирована логически грамотная структура сайта:

- URL-адреса соответствуют навигационной иерархии;

- использована поверхностная навигационная структура.

Иерархия - это не только отражение того, как организована и представлена информация на веб-ресурсе, но и то, насколько грамотно, удобно и осмыслено это сделано. В идеале об этом нужно подумать ещё на этапе разработки сайта, но все ещё уместно и вполне допустимо - внести определенные корректировки в самом начале внутренней оптимизации.

3. Настроена генерация ЧПУ - понятный человеку URL-адресов для всех страниц сайта:

- в адресе используется ключевое слово;

- URL достаточно короткий и не содержит непонятных символов;

- используются дефисы для разделения слов в адресе странички, а не нижнее подчеркивание;

- система управления содержимым не генерирует сессионных переменных в URL-адресе страниц;

- каталоги сайта не перегружены - число подпапок для URL минимально.

Грамотно составленные URL-адреса - это не только обеспечение лояльности со стороны поисковиков. Они будут удобны и для целевой аудитории. Так, пользователь сможет изначально понимать, что за страничку он открывает, видя и читая её адрес, а более продвинутым юзерам ЧПУ обеспечат достаточно простую и понятную навигацию по сайту.

Большинство современных «движков» позволяют настроить генерацию ЧПУ, так что все новые странички автоматически будут получать понятные и легко воспринимаемые адреса.

![]()

4. Составлены уникальные Title для всех страничек:

- для каждой страницы создан уникальный текст title;

- общее количество символов не превышает 60-70;

- в title включено одно ключевое слово;

- в мета-теге нет переспама ключей;

- текст тут короткий, но информативный;

- удалены все слова, традиционно ассоциируемые со спамом;

- в некоторые title вынесено название бренда для уникализации.

Мета-тег Title оказывает непосредственное влияние на позиции странички в поисковой выдаче. Информация тут прямо влияет на ранжирование, поэтому в ходе внутренней оптимизации для каждой странички нужно создать качественный, релевантный заголовок, исключить дубли и переспам.

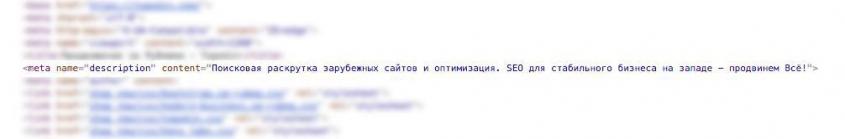

5. Созданы уникальные Description для всех страниц сайта:

- для каждой странички написаны уникальные описания;

- допустимое количество символов в Description - до 160 знаков;

- в описании упоминается основной ключ и один вспомогательный;

- все Description проверены на переспам: много ключевых слов - это плохо;

- в описании находится содержательный и полезный контент, который позволяет понять, чему посвящена страничка;

- в Description содержится текст, который ориентирован не только на поисковики, но и на реальных людей;

- для обеспечения индивидуальности в некоторые описания добавлено имя бренда/компании;

- в Description не используются слова, которые характерны для спама - дешево, бесплатно и т.д.

Поисковики используют данные из мета-тега Description для формирования сниппетов. То, что прописывается тут, в первую очередь увидит целевая аудитория в поисковой выдаче. Этот же блок текста может оказать непосредственное влияние на показатели кликабельности. Вот почему важно не просто создать релевантный страничке Description, но и убедить пользователя кликнуть по ссылке, ведущей на сайт.

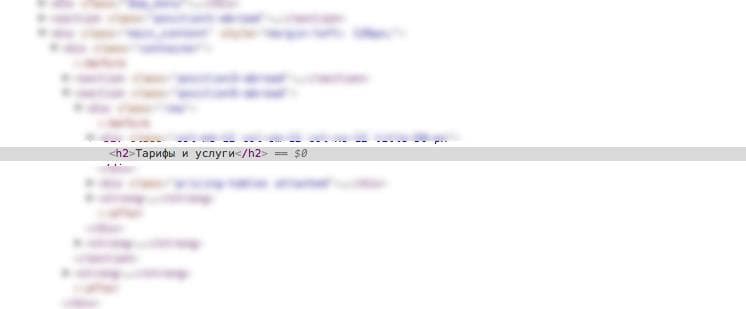

6. Оптимизированы теги Heading (H):

- одной страничке соответствует один тег H1;

- при использовании подзаголовков применяются теги H2-6;

- на большинстве страниц используются лишь теги H1-3, лишние подзаголовки не используются;

- тег H не используется с другими тегами, к примеру, оформления и выделения шрифта strong;

- в картинке тег H не используется (иначе это будет расценено поисковыми ботами, как спам).

H1 - это тег, в котором прописывается заголовок странички. Для информационных страниц - это название статьи или публикации, для интернет-магазинов - наименование раздела, название товара и т.д. Приветствуется интригующий контент в заголовке и подзаголовках, но при этом он должен быть на 100% уникальным, релевантным основному контенту и тому, что размещено в мета-тегах.

7. Прописаны теги Alt для изображений на сайте:

- каждая картинка имеет свое описание в теге Alt;

- приоритет с точки зрения SEO отдан именно Alt, а не тайтлу картинки;

- в описании используется около 5 слов;

- в текст Alt включен ключ;

- в описании картинки нет переспама.

Для имеющихся на сайте картинок рекомендуется прописывать альтернативный текст (в соответствующем теге), выводимый, если изображение не загружено (к примеру, отключена загрузка картинок в целях экономии мобильного трафика). К тому же поисковики по данным из тега Alt формируют выдачу поиска по картинке и учитывают его при ранжировании страничек по соответствующим запросам.

8. Устранены и/или закрыты от добавления в индекс все дубли страниц:

- определено основное зеркало сайта с www или же без;

- правильно настроен файл robots.txt;

- для поисковика Яндекса прописан основной хост в Роботс;

- главная страничка сделана недоступной по таким адресам, как /index.html или /index.php;

- настроена работа Canonical URL;

- все неактуальные URL-адреса переадресуют пользователей на новые странички;

- несуществующие странички выдают 404-ую ошибку;

- странички для печати, серверные логи, административная панель, бета-версии веб-ресурса на поддоменах закрыты от добавления в индекс;

- проверены другие потенциальные источники дублей страниц (к примеру, странички, которые оказались в supplemental results Гугла) удалены вовсе или закрыты от добавления в индекс.

Наличие дублей страниц может стать причиной пессимизации веб-ресурса в выдаче или даже его полного исключения из индекса. Чтобы обезопасить сайт от подобной проблемы необходимо устранить и/или закрыть от индексации дублированные странички. Для этих целей используется грамотная настройка файла robots.txt, применяется атрибут rel=“canonical”, правильно настраивается переадресация на сайте, прописываются основные зеркала и т.д. Задача всех этих работ проста - избавить ресурс от дублей или же показать поисковым ботом, что нужно индексировать, а что - нет.

9. Найдены битые ссылки:

- проверена работоспособность ссылок на внешние ресурсы;

- ресурсы, на которые ссылается площадка, все ещё актуальны и работают.

Битые ссылки негативно воздействуют на поведенческие факторы - пользователи не находят то, что им нужно и быстро покидают ресурс. Для поисковых систем битая ссылка - это признак ошибки на сайте, если их много, то уровень доверия снижается, а площадка считается некачественной. Чтобы этого не произошло, надо либо удалять, либо актуализировать ссылки - исправлять на рабочие.

Для поиска битых ссылок можно использовать Google Search Console. Во вкладке «Сканирование» найдите пункт «Ошибки сканирования». В инструменте вебмастеров Яндекса с поиском битых ссылок также проблем не возникнет. В разделе «Индексирование сайта» перейдите в «Исключенные странички», далее в «HTTP-статус». Вас должны интересовать ссылки со статусом «Ресурс не найден (404)».

10. Обеспечена высокая скорость загрузки страничек - до 2 секунд

Время, которое приходится ждать пользователю загрузки сайта, прямо влияет на его поведение. Если раньше допустимой задержкой считались 3-5 секунд, то сейчас многие не хотят ждать и больше 2 секунд. Заставляя ждать целевую аудиторию, вы не только рискуете увеличить показатель отказов - страничка попросту будет закрыта, но и ухудшить позиции в выдаче - поисковики уже учитывают данный параметр при ранжировании.

Оценить время загрузки позволит такой сервис, как PageSpeed Insights.

11. Соблюдено правило: не больше 100 ссылок на одну страничку сайта

Обилие внешних ссылок приравнивается к спаму. К тому же возрастает риск появления битых ссылок. Проиндексированные Гуглом будут лишь 100 ссылок с каждой странички, учтите это и не превышайте порога. Дополнительно для запрета индексации (для ссылок на сторонние ресурсы) рекомендуется использовать атрибут rel=nofollow.

12. Грамотно настроена внутренняя перелинковка:

- создана карта сайта в html-формате (для облегчения индексации страниц поисковиками);

- внизу публикаций есть от 3 до 10 ссылок на близкие по теме материалы;

- в самом текстовом контенте есть ссылки на другие публикации ресурса (оптимально от 5 до 10 штук);

- используются ссылки для картинок;

- создан сайтбар для каждой странички с упоминанием самых свежих публикаций или новостей.

Перелинковка внутри сайта способствует грамотному перераспределению веса и уровня траста между страничками ресурса. Это же хорошая возможность сделать навигацию по ресурсу ещё удобнее для целевой аудитории. Получить экспресс-анализ качества внутренней перелинковки позволяет сервис Google Search Console. Зайдите на вкладку «Поисковый трафик» и выберите раздел «Внутренние ссылки».

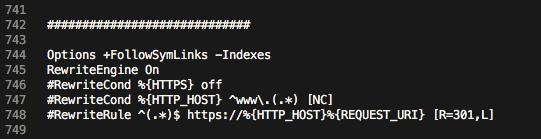

13. Настроен 301-й редирект

Благодаря правильной настройке перенаправления пользователей и поисковых ботов можно исключить ряд важных проблем, в том числе и с дублированным контентом. Так, даже два формата сайта с использованием www и без него поисковыми системами воспринимаются как отдельные площадки. Использование 301-го редиректа в большинстве случаев решает эту проблему, поэтому его правильная настройка является важным этапом внутренней оптимизации.

14. HTML-код проверен на валидность

Код сайта в идеале должен отвечать общепринятым нормам и стандартам. Любые ошибки и отклонения - это дополнительный риск неблагосклонного отношения поисковых системы. С помощью онлайн-инструментов, таких как, к примеру, W3C Markup Validation Service можно проверить html-код на наличие ошибок, посторонних элементов, нарушений в синтаксисе, вложенности тегов и т.д.

15. Сайт оптимизирован для индексации поисковыми ботами:

- код весит не больше 200 килобайт;

- применяемый на сайте Flash не содержит нужный/важный для индексирования контент;

- на страничках отсутствуют «тяжелые» фреймы;

- в коде нет ошибок и «мусора»;

- для страничек указана соответствующая кодировка.

По отдельности каждый этот момент может быть мелочью. Но вместе они прямо влияют на скорость добавления страниц сайта в индекс, косвенно и прямо воздействуют как на поведенческие факторы, так и на ранжирование.

16. Сайт размещен на надежном и быстром сервере

Этот момент прямо влияет на работоспособность и круглосуточный доступ к ресурсу пользователей и поисковых ботов. Если используемый хостинг сомнительного качества, то может ухудшаться скорость загрузки ресурса, поведенческие факторы, общий уровень доверия к компании/бренду со стороны целевой аудитории и поисковиков.

17. Настроены коды ответа сервера:

- в ответ на 404 ошибку выводится соответствующее, возможно креативное изображение (а не просто белый экран);

- корректно настроен Last-Modified;

- сервер выдает 304 ответ, если страничка не изменялась (настроен If-Modified-Since).

Эти коды ответа улучшают как поведенческие факторы (картинки на 404-ую ошибку и более высокая скорость загрузки данных с сервера), так и помогают поисковым ботам с индексацией, ускоряя её (If-Modified-Since и Last-Modified).

18. Создан файл favicon.ico

Наличие фавикона - это все ещё немаловажный элемент брендирования и идентификации сайта среди огромного числа аналогов и конкурентов. К тому же это изображение задействуют и поисковики, выводя его в результатах выдачи. Это можно и нужно использовать.

19. Файл favicon.ico загружен в корневой каталог сайта

Для вывода иконки ресурса в браузере и использования её поисковиками, нужно загрузить ранее подготовленное изображение в корневой каталог веб-ресурса.

20. Пользователи и поисковые боты видят одинаковое содержимое

Отсутствие скрытого текста и других когда-то используемых «хитростей» может повлечь санкции. В идеале и люди, и боты должны иметь дело с одинаковым контентом. В этом случае проведенную техническую оптимизацию можно считать грамотной и рассчитанной на долгосрочную перспективу.

21. Сайт проверен на наличие вирусов и вредоносного кода

Это немаловажная составляющая технической работы над сайтом. Для проверки можно использовать как обычное антивирусное ПО (скачав каталог сайта с сервера), так и специализированные сервисы. В идеале к работе лучше подключить опытного программиста, способного также выявить любые уязвимости и потенциальные угрозы.

22. Использована микроразметка для расширенного стиппета

Расширенные сниппеты удерживают внимание целевой аудитории и повышают уровень кликабельности. В целом, они выглядят более интересно, а порой и существенно информативнее, чем обычные описания, демонстрируемые в результатах выдачи.

Оглавление

- Услуги

- Продвижение сайтов

- Исправление репутации

- Создание сайтов

- Сопровождение сайтов

- Поддержка сайтов

не является публичной офертой.

seo & web develop

и отличаемся от других компаний тем, что у нас нет текучки в клиентах

и персонале. Мы полностью ориентированы на результат.

Начало – половина дела

Наша анкета достаточно проста и не отнимет у вас много времени.

Нужно просто правильно и вдумчиво заполнить все поля.

Форма заполнена на 0%

Базовые данные

Благодарим вас за обращение

Чтобы мы максимально точно смогли подобрать для вас программу продвижения,

внимательно заполните все поля нашей анкеты.

Форма заполнена на 0%

Шаг 2 – Информация о заявке

Мы гарантируем полную конфиденциальность и сохранность всей поступающей информации, а также личных данных и корпоративных секретов компаний

Отлично, остался всего один шаг!

Нам важно понимать, в какой сфере и для какого региона предстоит продвижение,

а точные данные позволят нашим аналитикам быстрее сформировать предложение.

Форма заполнена на 0%

Шаг 3 – Информация о компании

Наши специалисты ознакомятся с предоставленной информацией и сформируют для вас персональное предложение

Менеджер уже начал обработку данных

А вы пока можете узнать о нас немного больше, и понять почему мы именно так команда, которая сможет сделать для продвижения вашего проекта максимум.

Мы лидеры поиска

Google по запросу

«раскрутка сайтов»

... и по 7.000 другим аналогичным

запросам пользователей

Потому что мы ЛУЧШЕ других знаем

КАК отвечать на запросы

Мы используем только

белое SEO

Более 15 лет мы предлагаем услуги

по продвижению сайта в Google

по СНГ и за рубежом

Работаем только в соответствии с лицензиями поисковых машин: упор на оптимизацию, удобство для пользователей и контент.

Вместо покупки ссылок, с чем, кстати, активно борются поисковики, используем естественные ссылки с хороших ресурсов – в соответствии с рекомендациями Яндекс по работе со ссылками.

Обратившись к нам, вы 100% не навредите сайту.

Как это работает

Шаг 1 Вы запрашиваете информацию по вашему сайту.

Шаг 2 Мы анализируем ресурс и высылаем вам прогноз, где указан % увеличения конверсии за счет доработки сайта и целевых страниц.

Шаг 3 Мы подписываем с вами договор, где фиксируем финансовую ответственность за недостижение результата.

Шаг 4 Наши опытные веб-аналитики совместно со специалистами технической поддержки осуществляют комплекс необходимых работ для достижения прогноза.

Шаг 5 К указанному в договоре сроку конверсия вашего сайта вырастает (наш опыт показывает, что итоговый результат всегда выше прогноза!). Если этого не происходит, мы финансово отвечаем перед вами по договору.

Прозрачная тарификация

Наши цены несравнимо выгоднее конкурентов, потому что мы не тарифицируем и фильтруем:

- Мусорный и брендовый трафик

- Запросы и действия

- Стоимость и сроки Это экономит до 50% бюджета

Каждый сайт уникален. Именно поэтому точную стоимость услуги и сроки мы называем только после знакомства с ресурсом.

Приводим на 100%

качественных посетителей

На старте работы по проекту мы фиксируем такие показатели качества трафика как: время пребывания на сайте, глубина просмотра, показатель отказов или коэффициент конверсии.

Если один из показателей в процессе нашей работы падает ниже зафиксированного на старте, ваш ежемесячный платеж гарантированно снижается пропорционально падению.

Таким образом, вы можете быть уверены, что трафик, который мы приводим на ваш сайт, не накручен и является целевым на 100%.

Выполняем прогноз под

финансовую ответственность

в 20%

Прогнозируя увеличение трафика или целевых действий, мы несем ответственность за его выполнение.

Именно поэтому мы честно показываем те значения, на которые вы можете рассчитывать, исходя из технической готовности сайта, его наполнения и времени, которое планируется затратить на его продвижение. Это более чем трезвый расчет, который производится с учетом технологии предпроектного прогнозирования собственной разработки. За него несем финансовые гарантии по договору. Если по итогам месяца сотрудничества указанный прогноз не достигается, мы уменьшаем ваш платеж за текущий месяц на 20%.

Собственные

технологические

разработки

Автоматический

компоновщик запросов

Система оценка ссылочных

доноров

Собственные специализированные книги, статьи и публикации

Вам будет комфортно

потому что:

- Гарантируем выполнение работ по договору

- Обеспечиваем постоянную обратную связь

- у нас есть опыт продвижения сайта в различных уголках мира на разных языках

- Решения для вашей отрасли и структуры мы все сделаем сами.